В эпоху мэйнфреймов ИТ-подразделения обычно обязывали пользователей платить за использование системных ресурсов. Размер платы зависел от количества использованных ресурсов, а тариф отражал относительный приоритет пользователя, а также другие факторы, например, день недели. Фактически, возможности пользователя по оплате влияли на его приоритет (уровень предоставления услуг).

В то время выставление счетов за услуги было финансовой необходимостью, поскольку проведение расчетов на ЭВМ обходилось очень дорого.

— достаточно дорого, чтобы приходилось выставлять детализированные.

счета. К тому же, подсчет затрат технически был довольно прост. Задачи пользователей рассчитывались на одном компьютере, использование ресурсов которого было под контролем. Данные обычно хранились на съемных магнитных барабанах, каждый из которых соответствовал одному приложению. Принтеры и другие ресурсы были сконцентрированы в одном месте, и их использование было легко связать с конкретными задачами.

Так образом, мы видим, что в эпоху мэйнфреймов вычисления в очень большой степени производились по ресурсному принципу. Объемы услуг были ограничены, их поставка была централизованной, велся строгий учет использования ресурсов и выставлялись счета. Однако, в ассортименте имелась только одна услуга. Поскольку стоимость вычислений была очень высокой, они были доступны только для больших корпораций, правительственных и академических учреждений. Подразделениям, отдельным пользователям и населению эта услуга была недоступна.

|

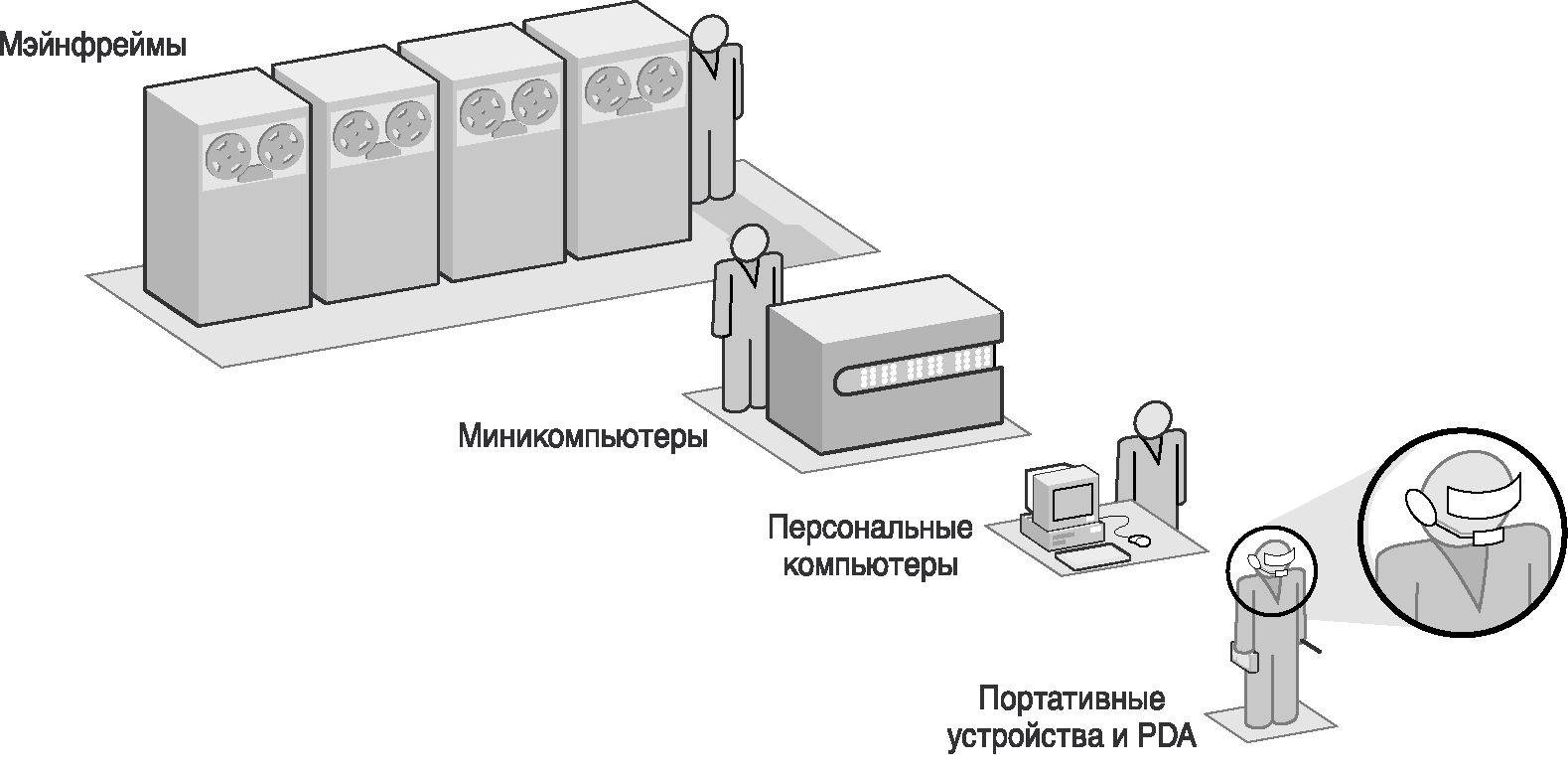

Рис. 4-1: Эволюция вычислительных технологий на предприятии |

Открытые системы и ресурсная модель.

В течение 1960-х и 1970-х годов технологии неуклонно двигались вперед, создавая все менее громоздкие и более дешевые компьютеры. В 1980-е годы появились открытые системы на основе операционной системы UNIX, позволившие унифицировать работу администраторов, сделав ее независимой от конкретной машины. В соответствии с этим возросло использование компьютеров, а также повсеместно, даже на малых предприятиях, стали применяться специализированные серверы, ориентированные на конкретные функции, например, обработку заказов и управление производственными ресурсами.

Парадоксально, но расширение использования компьютеров сократило использование ресурсной модели, поскольку одноцелевые недорогие компьютеры трансформировали вычисления из совместно используемого ресурса в статью расходов каждого отдельного подразделения. Вычисления превратились из услуги, предоставляемой центральным ИТ-подразделением, в услугу, предоставляемую внутри каждого подразделения на основе имеющихся в собственности этого подразделения компьютеров. Затраты на вычисления стали рассматриваться как капитальные затраты в рамках подразделения, а не как постоянная статья расходов, распределяемая между всеми подразделениями предприятия.

Персональные компьютеры.

В 1980-е годы вычисления стали доступными рядовым потребителям, с появлением сначала комплектов для сборки, а затем и готовых персональных компьютеров с полным набором функций. За это десятилетие цены на компьютеры резко упали и, соответственно, возросло количество пользователей и приложений. Люди смогли позволить себе покупать компьютеры, которые помогали им делать нужные и полезные вещи — писать письма, вести учет расходов и доходов, играть в игры и обмениваться электронными посланиями. Через очень небольшое время такие недорогие компьютеры появились и на предприятиях, вытеснив старые «глупые» терминалы, соединенные с большими серверами.

Полезность персонального компьютера растет по мере роста его мощности. Современные персональные компьютеры имеют производительность, равную производительности суперкомпьютеров 1990-х годов, и легко выполняют приложения, для которых раньше требовались большие центры обработки данных. Вычислительная мощность стала предметом широкого потребления — стоит недорого и может поставляться в виде заменяемых элементов множеством поставщиков.

Но низкая стоимость обработки данных сама по себе недостаточна для того, чтобы реализовались ресурсные вычисления; для этого необходима также распределительная сеть. Концепция ресурсных вычислений, описанная в предыдущих главах, была бы невозможна без одновременного развития другой информационной технологии — сетей Ethernet и, как следствие, повсеместного распространения локальных сетей.

Доступ к сети - главная опора.

С самых первых шагов развития компьютерной отрасли стало очевидно, что связь между компьютерами радикально повысила бы их полезность. Министерство обороны США с самого начала действовало в этом направлении — еще в 1960-х годах RAND Corporation занималась разработкой способов управления ракетами и системами безопасности США после ядерного удара. Ее исследования привели к разработке.

протоколов сетей с коммутацией пакетов с исключительно гибкой маршрутизацией и высокой устойчивостью к ошибкам.

Одноранговые сети.

Управление перспективного планирования научно-исследовательских работ правительства США (ARPA) на основе технологии коммутации пакетов построило одноранговую сеть ARPAnet. Сеть ARPAnet сначала связала между собой университеты; позже она включила в себя фирмы, выполнявшие заказы военных ведомств. Хотя соединять между собой компьютеры умели и раньше, сеть ARPAnet стала первой компьютерной сетью, обеспечивашей одноранговые связи между компьютерами — вместо такой структуры, когда главный компьютер посылает команды подчиненным компьютерам, здесь каждый компьютер мог послать запрос на услуги, который мог быть одобрен или отклонен другими компьютерами.

После появления сети ARPAnet технология одноранговой связи развилась в протокол управления TCP/IP и с тех пор используется в коммерческих сетях, поскольку и пользователям, и разработчикам сетей стало ясно, что с использованием этих новых стандартов связи между компьютерами открываются новые горизонты в ведении бизнеса. Недорогие вычисления стали возможны в непосредственной близости от пользователей и источников данных без необходимого ранее управления со стороны центра обработки данных. Больше того, для приложений типа электронной почты одноранговые отношения могли быть распространены вплоть до уровня персонального компьютера.

Технология Ethernet.

Протокол Ethernet был разработан в начале 1970-х годов с целью обеспечить недорогое быстродействующее соединение сотен компьютеров в центре обработки данных или университете. Его создание происходило по тому же пути, что и TCP/IP — сначала разработка в рамках консорциума, потом коммерческое внедрение, признание на рынке и затем стандартизация. Объединение Ethernet с протоколом TCP/IP сделало возможным взаимодействие удаленных и разнородных приложений, даже несмотря на различие их платформ. Тысячи локальных сетей Ethernet вошли в состав сетей предприятий и сетей общего пользования. С этого момента началась эра клиент-серверных технологий. В 1980-е годы правительственные организации, высшие учебные заведения и коммерческие предприятия создали магистральные сети, предназначенные как для объединения своих собственных подразделений, так и для взаимодействия (с помощью электронных средств) с другими предприятиями.

Благодаря протоколам Ethernet и TCP/IP предприятия могут использовать недорогие персональные компьютеры и небольшие серверы где угодно. Пользователи при этом перестают зависеть от центральной системы; они могут производить обработку данных даже при отсутствии подключения к сети. В результате как обработка, так и данные оказываются.

распределены по всему предприятию. Ресурсный аспект вычислений в масштабе предприятия сокращается еще больше из-за относительной независимости множества компьютеров, принадлежащих как подразделениям, так и отдельным пользователям и рассматривающихся почти как частная собственность их владельцев.

Как закон Мура предсказывает увеличение скорости обработки данных, так закон Гилдера предсказывает рост емкости компьютерных сетей. В 1995 году Джордж Гилдер постулировал, что суммарная пропускная способность развернутых сетей будет ежегодно увеличиваться втрое в ближайшие 25 лет, а пропускная способность отдельного подключения будет удваиваться каждые 9 месяцев. Развитие сетевой отрасли с тех пор и до настоящего времени подтверждают справедливость этого утверждения. Таким образом, элементы для возврата к ресурсным вычислениям имеются в наличии — недорогой товар широкого потребления (компьютерные мощности), который можно поставлять, и средства для его поставки (повсеместное распространение компьютерных сетей). Все, чего не хватает для возврата к ресурсным вычислениям, — это экономический мотив (зачем?) и механизм реализации (как?).

Интернет и возвращение к ресурсным вычислениям.

В 1990 году сотрудник ЦЕРН (Европейского центра ядерных исследований в Женеве) Тим Бернерс-Ли (Tim Berners-Lee) опубликовал основополагающую статью, в которой описывалась система с гипертекстовыми ссылками, предназначенная для совместного использования информации в рамках сообщества специалистов по физике высоких энергий. Статья тут же привлекла к себе внимание, и далее события развивались чрезвычайно быстро. В 1991 году увидела свет первая версия протокола HTTP (Hypertext Transfer Protocol), предназначенного для передачи текста между компьютерами с разной архитектурой, работающими под различными операционными системами. Это событие заложило основание современной сети World Wide Web.

В 1992 году ЦЕРН открыл доступ к Всемирной паутине для широкой публики. Количество компьютеров, подключившихся к сети, выросло с 1,1 миллиона в 1992 году до более чем 6,5 миллионов в 1995 г. Сегодня к сети Интернет подключены сотни миллионов компьютеров и других устройств. Телевизоры, игровые приставки, карманные компьютеры и другие устройства используют Интернет для распространения и поиска информации. Разработка, предназначенная изначально для текстов, позволила оперировать изображениями, аудио- и видеоинформацией. Передача в «живом эфире» телевизионных программ, компьютерные игры в реальном времени с несколькими соперниками, покупка товаров не выходя из дома стали сегодня обычным делом. Никогда еще такой огромный объем информации не был доступен такому большому числу людей настолько простым способом. Интернет вывел вычислительные технологии из сфе-.

ры коммерческих приложений и превратил их в универсальный ресурс, доступный каждому. Пенсионеры, двухлетние дети и все остальные люди, возраст которых находится в промежутке между этими двумя категориями, могут сделать свою жизнь значительно богаче благодаря Интернету.

Сегодня мобильные телефоны и карманные компьютеры получают информацию из Интернета в непрерывном режиме через службу GPRS (General Packet Radio Service). Как мобильный телефон позволил людям общаться независимо от того, где они находятся в данный момент, так Интернет дает возможность всегда иметь под рукой всю необходимую информацию независимо от того, где находится человек и какое сейчас время суток.

Новый облик концепции ресурсных вычислений.

Интернет вывел концепцию ресурсных вычислений на новый уровень благодаря виртуализации информационных ресурсов. Сегодня любой человек может найти в Интернете информацию практически на любую тему, не вдаваясь в подробности об инфраструктуре сети и источнике информации. Предприятию очень удобно создать свой Web-сайт и вести коммерческую деятельность через Интернет, а клиентам — делать покупки в комфортных условиях и не выходя из собственного дома.

Увидев быстрый успех Интернета, многие предприятия нашли способы использовать столь удачную концепцию для внутреннего применения. Пользовательские интерфейсы на основе браузеров позволяют обойтись без установки специальных приложений на каждом клиентском компьютере и без обучения пользователей работе с каждым новым приложением. Благодаря тому, что отпадает необходимость распространять, поддерживать работу и модернизировать каждое приложение на каждом клиентском компьютере, достигается весьма существенная экономия средств.

Изменения в компьютерных системах.

Интернет подготовил все для того, чтобы производить поставку информации по ресурсному принципу. Информация имеется в сети, и ее можно получить. Но ресурсный подход подразумевает постоянную доступность услуги так же, как потребитель всегда может пользоваться электроэнергией, стоит только включить в розетку электроприбор. Компьютеры не могут всегда поддерживать такой уровень готовности — они имеют обыкновение ломаться.

Начиная с середины 1990-х годов информационные услуги, для которых критически важна сохранность информации, защищены от компьютерных сбоев благодаря появлению средств аварийного переключения, которые осуществляют постоянный контроль работы приложений и перенаправляют их на другой компьютер при обнаружении неполадки. Сегодня технологии аварийного переключения позволяют объединять в кластеры десятки компьютеров. Приложения, работающие на входящих в кластер компьютерах, при неполадке компьютера могут сами перемещаться на.

другие компьютеры или перераспределяться, не требуя для этого вмешательства пользователей, которые чаще всего ничего не знают о том конкретном компьютере, с которым они взаимодействуют. Приложения виртуализировались

В современном центре обработки данных можно найти все необходимые составляющие для ресурсной технологии вычислений: недорогая обработка и хранение данных, сети поставки, универсальный пользовательский интерфейс (Web) для поставки услуги в любое место и в любое время и пользовательская мотивация (ценность информации и возможностей Интернета как для предприятия, так и для отдельных пользователей). Имеется даже правильное психологическое отношение — пользователи Интернета в высшей степени равнодушны к деталям, им просто нужно, чтобы услуга была доступна именно тогда, когда она им необходима.

Наращиваемые вычислительные системы.

В 1990-х годах произошли изменения конструкции и структуры поставки компьютеров и устройств хранения данных для предприятий. Пользователи пытались застраховаться от неожиданного роста нагрузок, и поставщики начали предлагать большие шасси, которые покупались бы в небольшой комплектации, с небольшим количеством дисководов, процессоров, памяти и т.п. Когда появлялась необходимость увеличения мощностей, к этой конфигурации можно было добавлять дополнительные компоненты, почти не нарушая ее работу. В области программного обеспечения тоже появилось нововведение — лицензии на определенное количество пользователей. В обоих случаях пользователи могли приобрести «большой ящик» по относительно низкой цене, а при появлении новых потребностей добавлять в него дополнительные мощности. Наращивание компьютерной системы можно было осуществить с помощью программного лицензионного ключа или путем установки дополнительных аппаратных компонентов.

Такой подход был шагом вперед, поскольку позволял предприятиям платить только за те ресурсы, которые им необходимы. Недостатком его была привязка предприятий к конкретному поставщику. Чтобы воспользоваться новой или более прогрессивной технологией другого поставщика, все инвестиции в «большой ящик» приходилось списывать.

Компании-разработчики программного обеспечения пошли еще дальше, введя оплату, зависящую от использования их продуктов.

Попытки такого нововведения в 2000 году провалились, но, учитывая произошедшее с тех пор замедление экономического роста, такое предложение становится для пользователей все более привлекательным, и давление на компании-разработчики программного обеспечения с целью заставить их принять такую модель продолжается. В случае, например, если предприятию требуется база данных для выполнения одно-двухмесячного проекта, такая схема оплаты позволила бы ему купить лицензию на срок выполнения проекта. Во многих случаях уменьшение стоимости лицензии уменьшило бы также периодические расходы на техническое обслуживание, обеспечив пользователям дополнительную экономию средств.

Ресурсные вычисления и компьютерная отрасль.

Крупнейшие поставщики аппаратного и программного обеспечения осознали привлекательность ресурсного подхода для пользователей, и многие из них уже сделали значительные технологические и маркетинговые шаги в этом направлении. В числе компаний, продвигающих идею ресурсных вычислений, можно указать:.

Hewlett-Packard (инициативы Adaptive Enterprise и Utility Data Center) IBM («Автономные вычисления») Microsoft (Dynamic Systems).

▼ Sun Microsystems (N1).

Вероятно, первой начала движение в этом направлении IBM, выступившая с амбициозной инициативой автономных вычислений (Autonomic Computing), целью которой является создание саморегулирующейся ИТинфраструктуры самоконфигурирующихся, самовосстанавливающихся, самооптимизирующихся и имеющих встроенную защиту серверов, сетей и приложений. Эта инициатива заставляет других поставщиков программного и аппаратного обеспечения по-новому взглянуть на архитектуру будущих ИТ-решений, однако должно пройти какое-то время, чтобы такой подход стал коммерчески реальным.

Компания VERITAS также развивает стратегию ресурсных вычислений, некоторые детали которой описаны в Главе 9. Стратегия VERITAS представляет собой единственный в своем роде многоплатформенный подход, основанный на программных технологиях. Этот подход не склоняет предприятия к каким-либо конкретным платформам серверов, систем хранения или сетевого оборудования. Стратегия VERITAS особенно подходит компаниям-системным интеграторам, некоторые из которых уже разрабатывают услуги по построению ресурсной ИТ-архитектуры. Бу-.

дучи программной, эта стратегия не требует массовой замены существующего оборудования, и потому выгодна с эволюционной точки зрения. Будучи многоплатформенной, она дает системному интегратору возможность применять накопленные знания у разных клиентов, независимо от того, какие платформы те используют.

Инициативы компаний-поставщиков в области ресурсных вычислений преследуют одну и ту же цель: обеспечить автоматическую динамическую настройку конфигурации аппаратных и программных ресурсов на основе упреждающих, основанных на правилах политик, чтобы улучшить использование ресурсов и снизить затраты.

Однако полная реализация идеи ресурсных вычислений — это нечто большее, чем большой набор недорогого программного и аппаратного обеспечения от одного поставщика. Сегодня центры обработки данных по самой сути представляют собой совокупность разнородных платформ. 1де-то в силу традиции, где-то потому, что специалисты сознательно стараются выполнять приложения на том оборудовании, которое для этого лучше всего подходит, но в итоге в большинстве центров обработки данных имеется впечатляющий набор оборудования, работающего под Linux, Windows и UNIX. В результате реализации ресурсной модели по меньшей мере часть этих ресурсов становится взаимозаменяемой — позволяя, например, использовать запас ресурсов хранения, предназначавшийся для электронной почты, для временного хранения данных по расчетам, производимым в конце месяца. При ресурсном подходе как вычислительные мощности, так и емкости хранения данных должны стать по-настоящему коллективными ресурсами, которые можно эффективно поставлять туда, где в них имеется нужда.

Стандарты.

В идеальном воплощении ресурсной модели приложения должны уметь находить другие приложения, предназначенные, например, для обработки и хранения данных, а также базы данных и другие ресурсы различных поставщиков, и взаимодействовать с ними. Ресурсы должны уметь взаимодействовать независимо от того, какая компания их разработала. История развития вычислительных технологий показывает, что для успешного взаимодействия ресурсов необходима стандартизация. Вот несколько ресурсноориентированных стандартов взаимодействия, которые находятся сейчас на начальных стадиях принятия пользователями:.

▼ Web Services Description Language (WSDL).

Universal Description Discovery and Integration (UDDI).

▼ Simple Object Access Protocol (SOAP).

▼ The Common Information Model (CIM).

The Storage Management Interface Standard (SMI-S).

Несмотря на то, что наличие таких стандартов несомненно означает прогресс, в некоторых отношениях они конкурируют между собой, и пройдет еще некоторое время, прежде чем они примут законченный вид. Пользо-.

ватели начинают постепенно принимать идею ресурсных вычислений, несмотря на отсутствие окончательно разработанных стандартов. Однако, обнадеживает уже сам факт такого принятия — история учит, что в компьютерной области принятие пользователями технологии скорее способствует разработке стандартов, чем разработка стандартов — принятию технологии.

Стандарты развертывания приложений пока еще остаются делом более далекого будущего. Сегодня каждый поставщик предлагает средства развертывания приложений, ориентированные на свою собственную платформу. Некоторые программные продукты поддерживают несколько платформ. Хотя они лучше, чем однонаправленные решения, но от идеала они пока еще далеки. Не имея стандартов взаимодействия, пользователи оказываются зажатыми в рамки однородной среды или, в лучшем случае, могут пользоваться несколькими «ресурсными» системами — по одной от каждого из поставщиков, чьи платформы имеются в их операционной среде.

Даже в случае одного приложения стандарты необходимы, так как обработка данных может производиться на разных платформах, например, к базе данных Oracle могут обращаться серверы, работающие под Windows или Linux. Без стандартизации формата данных пользователи не смогут в полной мере воспользоваться преимуществами ресурсных вычислений.

Взгляд в будущее.

Как среди производителей, так и среди сообщества пользователей все большую поддержку находит другая родственная ресурсным вычислениям инициатива — распределенные сетевые вычисления (Grid). Будучи внедренной в полном объеме, Grid-технология сможет объединить все доступные компьютерные ресурсы и организовывать решение задач в рамках всей образовавшейся системы. В некотором смысле эта технология представляет собой абсолютное воплощение ресурсного подхода — пользователи смогут подключаться к Grid, пользоваться нужными ресурсами и снова отключаться. До некоторой степени Grid будет похожа на сегодняшние коммунальные службы — поверни кран и пользуйся водой столько, сколько хочешь; подними телефонную трубку и говори по телефону столько, сколько нужно.

Такой уровень ресурсных вычислений пока еще остается делом будущего, хотя уже сегодня есть определенные сдвиги в нужную сторону. Совместная работа и объединение ресурсов сейчас используются в фармацевтической и финансовой областях, автомобилестроении и мультипликации. Но и здесь крайне редко встречаются приложения, полностью реализующие преимущества, заложенные в идее Grid.

Вернемся к утверждению Томаса Уотсона, приведенному в начале этой главы. Возможно, г-н Уотсон был не так уж и неправ. Если под «компьютером будущего» подразумевать множество соединенных в сеть компьютеров, предоставляющих свои приложения всем желающим, можно предположить (только предположить!), что, может быть, лет через 20 останется только горстка (пять?) мировых провайдеров, как это произошло сейчас в сфере снабжения электроэнергией, телекоммуникационных услуг и множестве других услуг в коммунальной сфере.

Выводы.

Основные положения концепции ресурсных вычислений — централизованно предоставляемые услуги общего пользования, коллективное использование ресурсов, а также учет затрат и потребления — так же стары, как сами компьютерные технологии.

Ресурсная модель вычислений вышла из употребления, когда появление недорогих и простых в использовании компьютеров позволило пользователям (коммерческим и управленческим подразделениям) самим управлять обработкой своих данных.

Вместе с тем, стандартизация сетевых технологий, а также доступность и относительная дешевизна обработки и хранения данных создали предпосылки для возвращения к ресурсной идее на новом этапе ее развития.

Другие изменения и тенденции в использовании и приобретении программного и, в некоторой степени, аппаратного обеспечения также внесли свой вклад в возврат к идее ресурсных вычислений.

В конечном счете для полной реализации концепции ресурсных вычислений потребуются стандарты, начиная от протоколов взаимодействия приложений до управления инфраструктурой самой услуги. Для полного завершения разработок этих стандартов как с технической, так и с политической точек зрения потребуется еще некоторое время, однако признание пользователями идеи ресурсного подхода к вычислениям позволяет надеяться на ускорение этого процесса. Концепция ресурсных вычислений, как она понимается в настоящее время, возможно, всего лишь ступень перехода к еще более гибкой среде обработки информации, известной сегодня как Grid.

Этапы перехода.

Выше мы определили четыре важнейшие отличительные черты компаниипоставщика ресурсных услуг: большая клиентская база, небольшой набор четко определенных услуг, надежный механизм предоставления услуг, учет потребления — и объяснили, почему ресурсная модель работает для поставки одних товаров и услуг и не работает для других. Мы пришли к выводу, что ресурсная модель должна хорошо работать при предоставлении пользователям (подразделениям и управленческим структурам предприятия) базовых ИТ-услуг, и предварительно рассмотрели некоторые препятствия, с которыми ИТ-службы могут столкнуться при внедрении ресурсной модели. В этой части мы говорим о том, каким образом предприятие может принять решение о внедрении ресурсного подхода к ИТ и спланировать такое внедрение, и рассматриваем гипотетический пример внедрения и некоторые его результаты.